谷歌Gemini被曝安全漏洞?AI模型攻击面全景分析

在当今人工智能飞速发展的时代,谷歌的 Gemini 作为其重磅推出的大型语言模型,引发了广泛的关注与期待。近期关于谷歌 Gemini 被曝存在安全漏洞的消息,如同投下的一颗重磅,让整个业界为之震动。这一事件不仅引发了人们对 AI 模型安全的深刻反思,也促使我们对 AI 模型的攻击面进行全面而深入的分析。

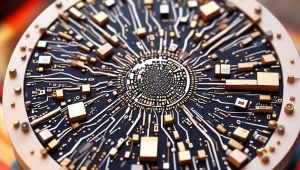

让我们来了解一下什么是 AI 模型的攻击面。简单来说,攻击面就是黑客或恶意攻击者能够利用的系统或模型的弱点和漏洞。对于像谷歌 Gemini 这样的大型语言模型,其攻击面可能涉及多个方面,包括模型的训练数据、模型架构、模型的接口和交互方式等。

从训练数据的角度来看,谷歌 Gemini 是基于大量的文本数据进行训练的。如果这些训练数据中存在隐私信息、错误信息或恶意内容,那么攻击者就有可能利用这些数据来对模型进行攻击。例如,攻击者可以通过分析训练数据中的特定模式或词汇,来推断出模型的内部结构或敏感信息,从而实现对模型的攻击。

模型架构也是 AI 模型攻击面的一个重要方面。谷歌 Gemini 采用了复杂的深度学习架构,这种架构虽然能够赋予模型强大的语言理解和生成能力,但也同时存在一些潜在的安全风险。例如,模型可能存在过拟合的问题,即过度学习训练数据中的特定模式,而无法泛化到新的数据上。这种过拟合现象可能会导致模型在面对一些未知的攻击时表现出脆弱性。

模型的接口和交互方式也可能成为攻击者的目标。谷歌 Gemini 通常会提供一些接口,以便开发者和用户能够与模型进行交互和使用。如果这些接口存在安全漏洞,例如输入验证不严格、权限管理不当等,那么攻击者就有可能利用这些漏洞来对模型进行攻击,甚至获取模型的控制权或敏感信息。

那么,对于谷歌 Gemini 被曝的安全漏洞,我们应该如何进行全景分析呢?我们需要对漏洞的具体情况进行深入的调查和了解。这包括漏洞的类型、影响范围、严重程度等方面的信息。通过对这些信息的掌握,我们可以更好地评估漏洞的风险,并采取相应的措施来进行修复和防范。

我们需要对谷歌 Gemini 的安全机制进行全面的评估。这包括模型的加密保护、访问控制、数据备份等方面的机制。通过对这些安全机制的评估,我们可以了解到谷歌 Gemini 在安全方面的措施是否足够强大,是否能够有效地抵御各种攻击。

我们还需要加强对 AI 模型安全的研究和开发。这包括开发更加安全的 AI 模型架构、加强对训练数据的安全管理、提高模型的抗攻击能力等方面的工作。只有通过不断地研究和开发,我们才能够更好地保障 AI 模型的安全,避免类似的安全漏洞再次发生。

我们也需要加强对 AI 模型安全的监管和管理。和相关机构应该制定更加严格的安全标准和法规,对 AI 模型的开发和使用进行规范和监管。也需要加强对 AI 安全领域的人才培养,提高整个行业的安全意识和技术水平。

谷歌 Gemini 被曝安全漏洞事件给我们敲响了钟,让我们深刻认识到 AI 模型安全的重要性。在未来的发展中,我们需要加强对 AI 模型安全的研究和开发,加强对 AI 模型安全的监管和管理,共同努力保障 AI 模型的安全,推动人工智能技术的健康发展。